本文聚焦英伟达在GTC 2025大会上的表现以及其面临的挑战与机遇。详细介绍了近期英伟达股票下跌的背景,分析了DeepSeek对英伟达带来的冲击,同时阐述了黄仁勋在大会上的回应,探讨了“token时代”英伟达的发展前景以及其产品的实际表现和市场反应。

在GTC 2025大会上,身着皮衣的黄仁勋显得意气风发。然而,近期英伟达的股票却遭遇了严重下滑,甚至跌至10年来的最低点。但这似乎并未影响黄仁勋对英伟达最新GPU产品的信心。

时间回溯到2月初,DeepSeek的发布在AI领域引起了巨大轰动。这一由中国团队研发的产品,仅使用少量以A100为主的低端GPU,通过蒸馏现有超大模型,就实现了以H100为代表的高端GPU才能达到的性能。这一成果的出现,让高端GPU不再被视为刚需,过去在AI行业中被奉为圭臬的“Scaling Law”(规模定律),即“模型参数量、数据集、训练成本越多越好”的观念受到了严重挑战。

此前,谷歌、Meta、微软等互联网大厂为了在AI竞争中占据优势,纷纷大量采购H100芯片,试图以强大的算力来决定胜负。但如今,即使不依赖如此庞大的算力规模,大模型也能拥有媲美OpenAI o1的性能。一时间,“DeepSeek将让英伟达走向末路”的言论甚嚣尘上,尤其是在海外社交媒体平台上传播迅速。有X网友直言“英伟达的一切都将开始瓦解”,那段时间英伟达股票一天下跌13%、17%都成为了常态。

不过,也有观点认为,从长远来看,DeepSeek的成功反而对英伟达有利。虽然DeepSeek通过“蒸馏现有超大模型”的方法训练大模型时不需要用到H100芯片这样的高性能计算卡,但这并不意味着完全不依赖计算卡。实际上,它使用的A100计算卡同样是英伟达的产品。随着玩家进入门槛的降低,市场上参与的玩家会越来越多,整体对算力的需求也会相应上升。而英伟达作为全球最大的计算卡供应商,有望卖出更多的产品。此外,要进行超大模型的蒸馏,首先需要有性能出色的超大模型,而这离不开H100这样的计算卡集群来进行训练,这就形成了一个类似“先有鸡还是有蛋”的问题。

大家都十分期待黄仁勋本人对此事的看法。在本次GTC 2025大会上,我们终于等到了他的回应。

依旧是GPU霸主

按照惯例,我们先来回顾一下这场门票高达1万美元的“科技盛宴”。在此次大会上,英伟达主要发布了四款芯片架构、两款AI电脑、一款AI训练底层软件,并展示了具身机器人相关的进展。

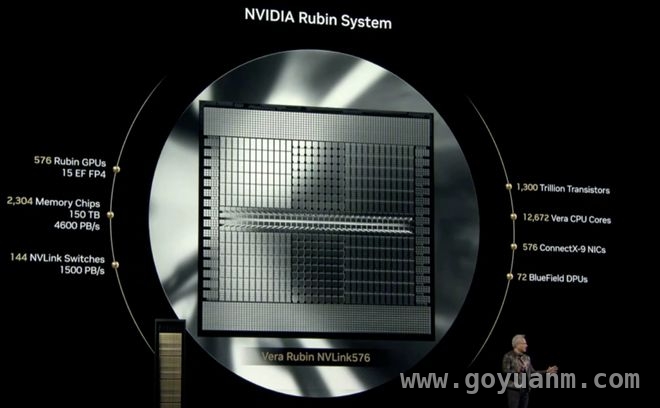

– 4款AI芯片架构分别为:将于2025下半年发布的Blackwell Ultra、2026下半年发布的Vera Rubin、2027下半年发布的Vera Rubin Ultra以及2028年推出的Feynman。全新的超级芯片产品中,基于Blackwell Ultra架构的GB300 NVL72芯片是上一代最强芯片GB200的继任者。但其推理性能仅为GB200 NVL72的1.5倍,提升幅度并不大,甚至在大会上GB300的直接对比对象还是2年前的H100。

从市场反应来看,大部分人对GB300并不买账,它没有给人带来上一代GB200那种“横空出世”的惊喜感。其最大的升级点可能是HBMe内存提升至288GB,这就好比苹果今年发布的新机是2TB版本的iPhone 16 Pro Max。不过,英伟达未来的芯片架构规划才是重头戏。下代超级芯片Rubin NVL144比GB300 NVL72强了3.3倍,下下代的Rubin Ultra NVL576性能更是GB300 NVL72的14倍。从规划的性能来看,未来英伟达大概率仍将掌握GPU算力的王座。

– 两款全新的AI电脑分别是:搭载了GB10 Grace Blackwell超级芯片的DGX Spark,每秒可提供高达1000万亿次AI运算;搭载了GB300 Grace Blackwell Ultra的DGX Station,每秒可提供高达2000万亿次AI运算。目前,DGX Spark已经开始预售,售价为3000美元。

– 开源软件NVIDIA Dyamo,可以简单理解为一款AI工厂(数据中心)的操作系统。英伟达表示,在NVIDIA Blackwell上使用Dynamo优化推理,能让DeepSeek – R1的吞吐量提升30倍。

– 具身机器人方面,英伟达展示了其技术储备,包括机器人通用基础模型Isaac GR00T N1、配备了GR00T N1模型的机器人Blue,以及与Google Mind、迪士尼合作的最新成果。

从发布的产品来看,英伟达仍然是GPU领域的霸主,其领导地位甚至开始向AI领域拓展。英伟达不仅将产品技术路线图更新至一年一更,未来三年的产品规划更是堪称“超级大饼”。同时,围绕AI相关的软件建设也在快速推进,NVIDIA Dyamo很可能会成为未来数据中心的标配。对于DeepSeek带来的冲击,英伟达似乎也已经有了应对之策。

步入“token时代”

在此次大会上,黄仁勋首次在公开场合正面回应了DeepSeek诞生以来对公司造成的冲击。他首先对DeepSeek进行了高度评价,称DeepSeek R1模型是“卓越的创新”和“世界级的开源推理模型”,并表示不理解为什么大家会认为DeepSeek是英伟达的末日。

对于因DeepSeek引发的关于Scaling Law失效的讨论,黄仁勋在会上给出了自己的见解。他对Scaling Law进行了一次迭代更新,将其细化为PRE – TRAINING SCALING、POST – TRAINING SCALING、TEST – TIME SCALING三个部分。他认为,随着AI的发展进入不同阶段,对Scaling的需求会不断提高。

黄仁勋将AI的发展分为四个阶段:感知人工智能(Perception AI)、生成式人工智能(Generative AI)、代理人工智能(Agentic AI)和未来的物理AI(Physical AI)。目前,我们正处于代理人工智能阶段。在这个阶段,由于推理模型和AI代理的大量涌现,实际上对Scaling和算力的需求更为迫切。

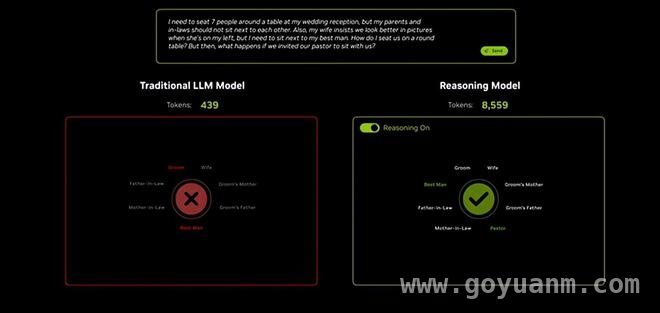

这背后的关键因素是token。以推理模型为例,在模型进行推理时,token的消耗会急剧增加。黄仁勋表示,我们不仅需要将token的吞吐量提升十倍,还需要过去10倍的算力来提高token的输出速度,最终所需的算力将是之前的100倍。从技术角度来看,这是有一定道理的。与传统的生成式模型(如ChatGPT)相比,拥有思维链的推理式模型(如DeepSeek R1)会有一连串的推理过程,有时推理过程的字数甚至比答案还要多。R1模型能够实现推理,是因为它会将输出的token返回上级进行重新思考和推理,就像黄仁勋所说的“每个token都会自我怀疑”。在不断的怀疑 – 论证过程中,形成了推理过程,但这也会消耗更多的算力和token。推理模型消耗的token数量比传统生成式模型多20倍,而不是2倍。

当我们使用推理模型时,前台会展示出一大串的思考和推理过程,这不仅是为了让用户能够介入修正答案,更重要的是这些过程都在消耗token,是需要付出成本的。而且,随着市面上推理模型的不断增多,更多传统模型也开始加入推理过程,例如谷歌的Gemini。最终,token的消耗将呈指数级增长。这就是黄仁勋坚信Scaling Law没有失效的底气所在。在会上,他用传统模型Llama 3.3 70B与DeepSeek R1 671B进行对比,统一回答一个复杂问题。结果显示,前者消耗了400多个token但结果不可用,而后者的结果堪称完美,但消耗了足足8559个token。或许从蒸馏大模型中节约的算力,又会在推理过程中被消耗掉,这就如同AI算力中的能量守恒。

DeepSeek助力英伟达GPU销售

除了黄仁勋的精彩论证,在这个高token消耗的时代,英伟达的GPU销售情况确实更加火爆。彭博社报道称,OpenAI预计在「星际之门」首期计划中,建立一个可容纳40万个英伟达AI芯片的数据中心综合体。如果全部装满,这将成为世界上最大的AI算力集群之一。

对算力极为推崇的马斯克,其旗下的xAI已与戴尔达成50亿美元协议,用于在孟菲斯建设超级计算机的AI服务器。Meta也宣布计划拥有相当于600,000块英伟达H100芯片的算力。此外,国内的阿里、小米、腾讯等公司也将部署海量算力作为主要目标。这些公司背后的显卡供应商,毫无疑问主要是英伟达。推理模型普及后,大公司对计算卡和算力的热情丝毫未减,这表明至少大公司仍然坚信未来是算力的时代。

在个人本地部署领域,DeepSeek R1也并没有真正减轻个人用户的算力负担。2月中旬,全网掀起了一阵本地部署DeepSeek R1蒸馏模型的热潮。但从个人经验来看,要想获得较好的模型性能,对电脑配置(即算力)的要求并不低。以RTX 4080 16GB显卡为例,它拥有9728个CUDA核心,16GB GDDR6X的显存带宽为736 GB/s,在显卡中属于高端产品。但用它在本地部署14B的DeepSeek R1蒸馏模型时,大部分的推理速度只有20 – 30 tokens/s,分析深度问题往往需要等待超过10分钟。如果用它来部署32B的蒸馏模型,推理速度会进一步下降到5 – 15 tokens/s,生成同样的回答需要等待超过30分钟。这样的效率显然无法满足需求。如果想要提高推理速度,有两个选择:一是选择更小参数的蒸馏模型进行部署,但这会导致推理精度和答案可靠性明显下降;二是选择更高配置的硬件,如RTX 5080/5090。用5090部署32B的蒸馏模型,推理速度能达到50 – 60 tokens/s,效率明显提升,但这也正中了英伟达卖卡的计划。也许对于大多数人来说,本地部署的大模型还不如直接使用腾讯元宝高效。

由此可见,从DeepSeek R1引申出来的“蒸馏模型节省训练算力”已经被“推理模型消耗算力”所抵消,这为英伟达带来了全新的机遇。可以说,DeepSeek的出现虽然给英伟达关上了一扇门,但同时也为其打开了一扇窗。从长远来看,算力的需求还会不断增加,这对英伟达是利好的。尽管今年Blackwell Ultra的升级幅度较小,但后面几年的芯片架构预计会有明显的算力提升。当各大厂的算力吃紧时,英伟达的高端产品将有更多的用武之地。

是贩卖token焦虑吗?

纵观GTC 2025大会,只要涉及AI、GPU、算力等方面,黄仁勋总会提及token,甚至有媒体专门统计了他在会上提到“token”的次数,颇具趣味性。在新Scaling Law时代,token似乎成了英伟达的救命稻草。虽然从逻辑上看,黄仁勋的观点有一定道理,但如此频繁地重复一种逻辑,难免会让人觉得英伟达有些歇斯底里。

自农历新年以来,英伟达的市值已经跌去了将近30%。在这次发布会上,黄仁勋不再像以往那样展现出技术大拿的风采,更像是一个喋喋不休的金牌销售,试图通过贩卖token焦虑来让大家相信英伟达仍然掌握着未来。然而,投资者的信心来源于产品而非推销和布道。今年下半年即将面世的GB300确实没有太多亮点,而未来的规划又较为遥远。发布会结束后,英伟达的股价依然下跌了3.4%。

更让人哭笑不得的是价值3000美元的DGX Spark。根据官网披露的信息,这款产品的128GB内存,带宽只有273GB/s。尽管黄仁勋将其定义为“可用于本地部署”的AI电脑,但其实性能实在不敢恭维。它甚至无法高效运行大部分32B的模型,更不用说满血版671B的DeepSeek R1了。用它来运行传统模型或许还可以,但运行推理模型则会非常困难。或许它的存在意义仅仅是为了促使大家购买更强的DGX Station。如果英伟达一直在强调token焦虑,那么最好能拿出更多能够解决token焦虑的产品。英伟达在GPU领域技术领先,但真正缺乏的是对消费者的诚意。

本文围绕英伟达在GTC 2025大会的表现及面临的挑战与机遇展开。DeepSeek的出现冲击了英伟达的市场地位和传统观念,但也为其带来新机遇。黄仁勋通过更新Scaling Law和强调“token时代”的算力需求,展示了英伟达应对挑战的策略。尽管当前产品存在不足且股价下跌,但长远来看,算力需求增加仍利好英伟达,不过它需要提升产品诚意以赢回投资者和消费者的信心。